La R&T R2D2: recherche d’événements rare en physique des neutrinos

L’utilisation possible d’un compteur proportionnel sphérique pour la recherche de la désintégration double bêta sans neutrinos est étudiée dans le cadre du projet R2D2. Double

La lecture de de la double charge et de la lumière scintillation peut améliorer les performances de détection du signal rare à trouver.

Les chambres sphériques à projection temporelle (TPC), également appelées compteurs proportionnels sphériques, sont employés dans la recherche de phénomènes rares, tels que les candidats légers à la matière noire. La TPC sphérique présente un certain nombre de caractéristiques essentielles, ce qui en fait un candidat prometteur pour la recherche de la double désintégration bêta sans neutrinos (𝛽𝛽0𝜈). Une expérience de TPC sphérique à l’échelle de la tonne pourrait couvrir une région de l’espace des paramètres pertinente pour la hiérarchie de masse inversée avec quelques années de données prise. Dans ce sens, l’objectif majeur de R&D de l’effort R2D2 est la démonstration de la nécessaire résolution énergétique. Les premiers résultats d’un prototype de détecteur rempli d’argon démontrent une résolution en énergie de 1,1% FWHM pour des pistes de 5,3 MeV 𝛼 dans la plage de pression de 0,2 à 1,1 bar.

Comme le signal en sortie de détecteur est intégré pour optimiser l’amplification des faibles signaux, la détection de deux électrons simultanés nécessitent un traitement du signal optimal sous forme de problème inverse. Mais mathématique, l’algorithme fait parti des problèmes mal-posés au sens de Hadamache. On peut alors envisager l’utilisation d’un réseau de neurones qui classera les signaux selon plusieurs catégories comme des signaux multi-évènements. En remontant cette information, une alarme pourra être déclenchée pour une analyse fine de l’évènement en question.

Dans ce cadre, nous avons travaillé sur la labellisation des signaux et l’apprentissage par un réseau de neurones profond des différentes catégories de signaux. Ci-dessous sont présentés les étapes et les résultats préliminaires.

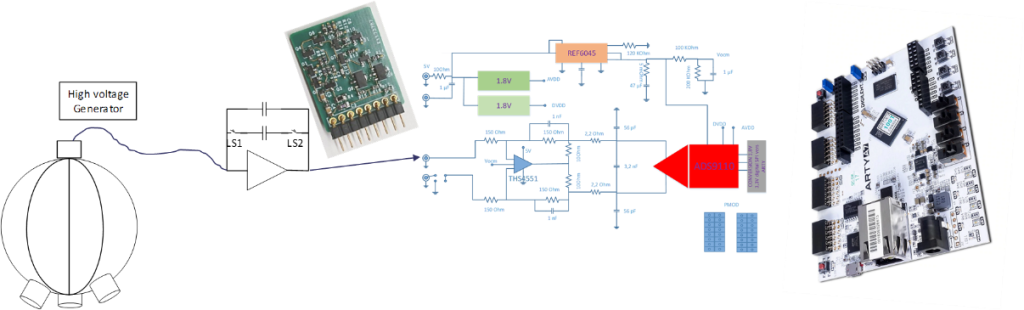

Schéma de principe

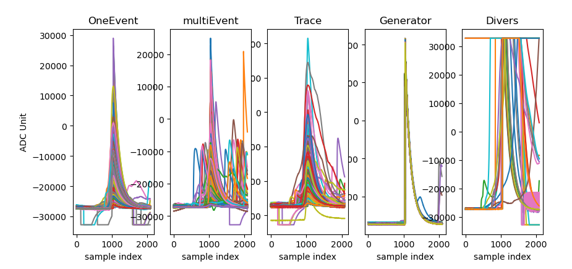

Labellisation des signaux

Aprés avoir enregistré quelques dizaines de milliers de signaux issus du detceteur, nous avons automatisé la labellisation pour avoir un jeux de données d’apprentissage. Le résultat de cette phase est representé ci-dessous:

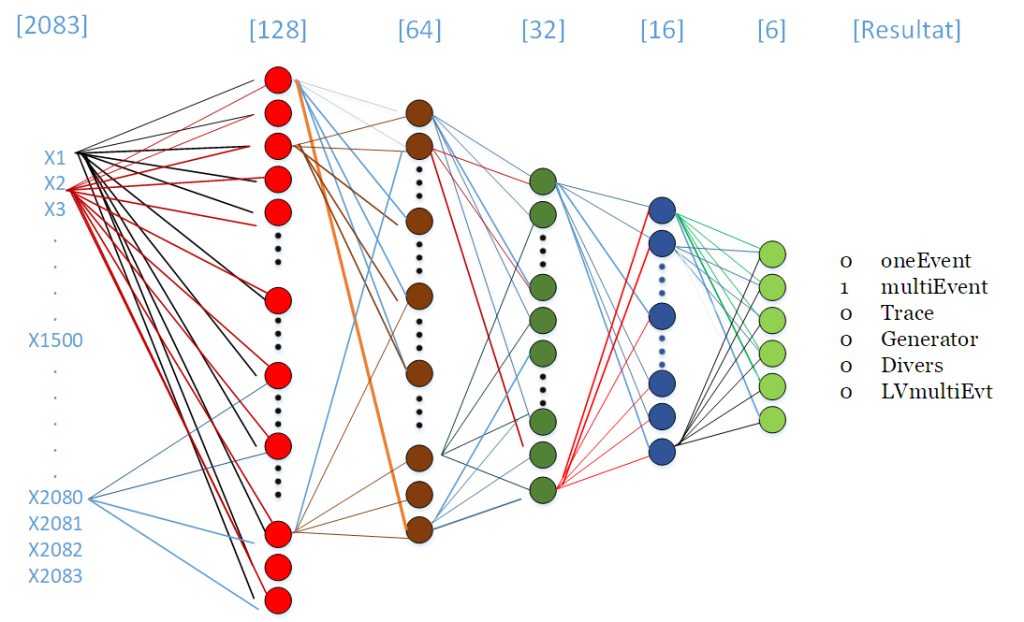

Nous avons défini un réseau de neurones de dimensions 2083x128x64x32x16x6.

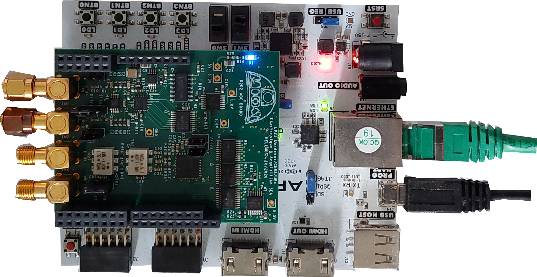

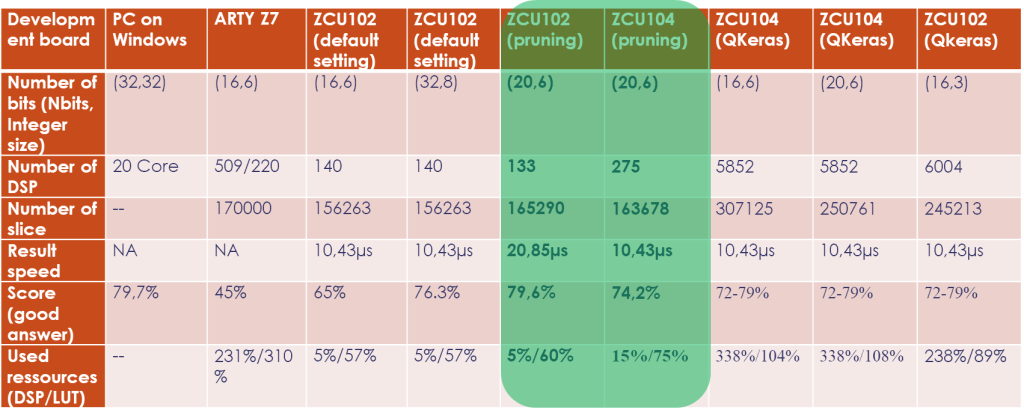

En reprenant la méthodologie décrite à la page –HLS4ML-Xilinx-, nous obtenons les résultats ci dessous. Nous avons testé le réseau pour des cartes Soc Arty Z7, ZCU104 et ZCU102.

résultats suivant le composants Xilinx:

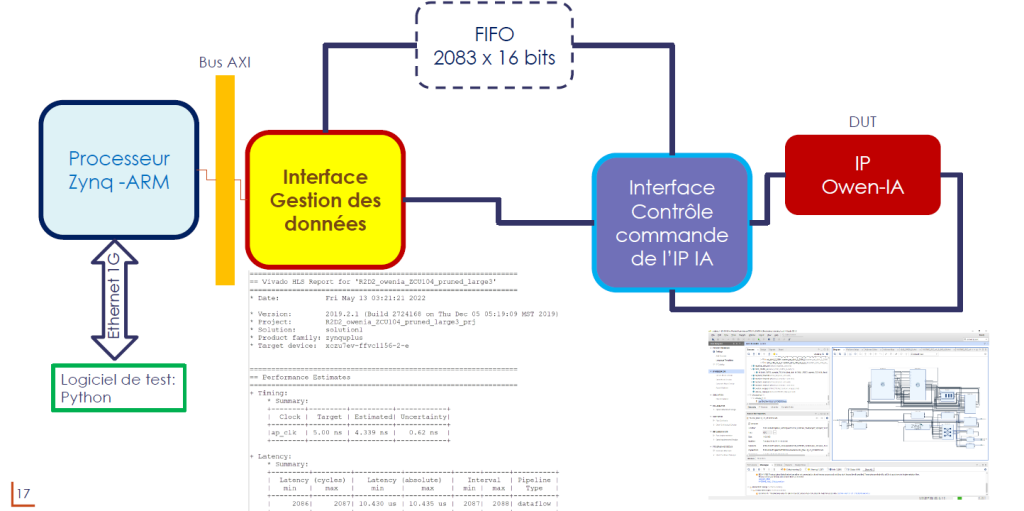

Intégration de l’IP DNN dans un FPGA Zynq ZCU102

Pour vérifier le comportement du réseau, nous devons développer un système DAQ permettant de fournir les données d’entrées à l’IP et de réceptionner le résultat de son calcul. L’architecture privilégié est un client serveur permettant de communiquer à travers un lien TCP/IP.

Pour chaque catégorie, on a le pourcentage de bonnes et mauvaises réponses suivantes :

| Categories | % Bonnes reponses | % Mauvaises réponses |

| oneEvent | 52.4 | 47.6 |

| MultiEvent | 61.3 | 38.7 |

| Trace | 43.4 | 56.6 |

| Generateur | 94.0 | 6.0 |

| Divers | 98.3 | 1.7 |

| Signaux_faibles | 99.4 | 0.6 |

conclusion

En combinant les catégories oneEvent, MultiEvent et Trace, on a un taux de bonne réponse de 70%. On a donc une implémentation du réseau de neurone qui fonctionne correctement mais les calculs réels montrent une insuffisance dans la prise de décision sur les catégories. On peut analyser ce fait suivant deux hypothèses :

- Les signaux d’entrées sont très semblables et la labellisation est faite sur des aprioris. C’est une faiblesse de l’architecture de ce réseau pour cette problématique. On peut aussi voir que le nombre d’échantillon d’entrées reste faible par rapport à la problématique de reconnaissance de la forme d’ondes. Donc, la phase d’apprentissage montre que la précision sur les coefficients est le paramètre important pour la prise de décision.

- La phase d’élagage et de quantification a été réalisé après l’apprentissage. Il y a donc un risque que les dimensions des coefficients soient une des faiblesses de cette implémentation.